所属分类:php教程

程序员必备接口测试调试工具:立即使用

Apipost = Postman + Swagger + Mock + Jmeter

Api设计、调试、文档、自动化测试工具

后端、前端、测试,同时在线协作,内容实时同步

文章目录

(免费学习推荐:python视频教程)

一、前言

之前爬取了很多静态网页的内容,包括:小说、图片等等,今天我来尝试一下动态网页的爬取。众所周知,百度图片就是一个动态网页。那么,冲!冲!!冲!!!

二、需要导入的库

1 | import requestsimport jsonimport os |

三、实现过程

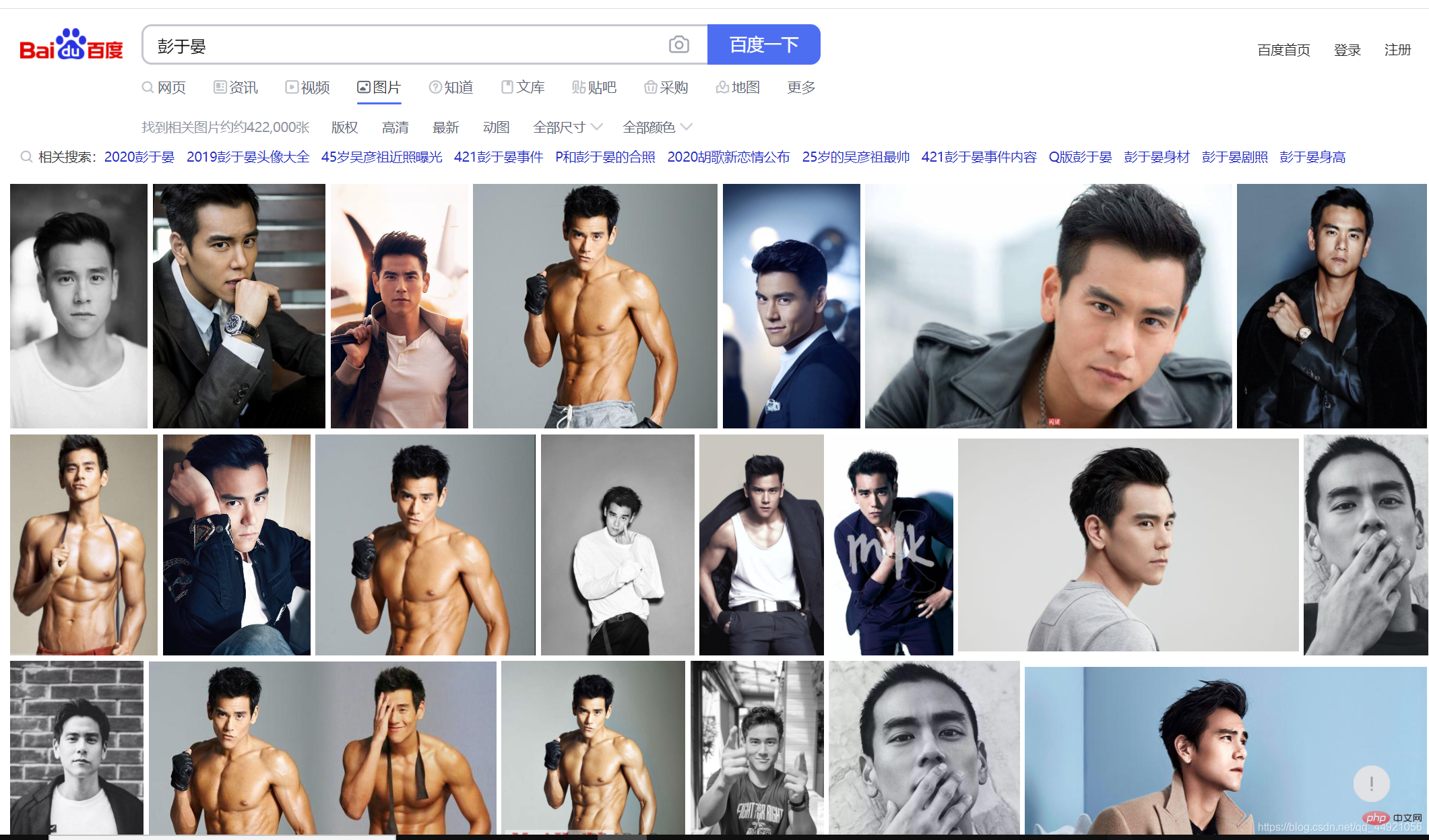

首先,打开百度,搜索一个内容,这里搜索的是男神(本人 )——彭于晏

然后,打开抓包工具,选择XHR选项,按Ctrl+R,然后你会发现,随着你鼠标的滑动,右侧会出现一个又一个的数据包。

(这里没滑动太多,一开始因为滑动太多,录的GIF超5M了)

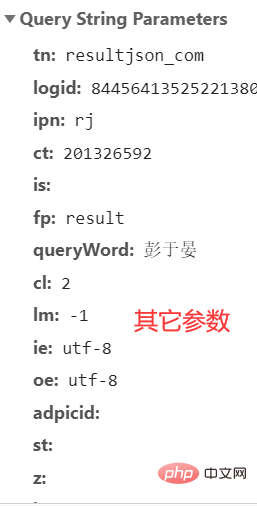

然后,选一个包,查看它的headers,如图:

截取之后,粘贴在记事本上,作为一个URL,后文会用到。

这里有很多很多的参数,我也不知道具体哪些是可以忽略的,后文就索性全复制下来了,具体看后文。

到这里,能够直接观察到的内容就结束了,接下来,借助代码,帮我们打开另一个世界的大门

冲就完事了!

首先:把上述中的“其它参数”组在一起。

自己做的话,最好复制自己的“其它参数”。

之后,我们可以先提取一下试试,并且把编码格式改成'utf-8'

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 | param = { 'tn': 'resultjson_com', 'logid': ' 7517080705015306512', 'ipn': 'rj', 'ct': '201326592', 'is': '', 'fp': 'result', 'queryWord': '彭于晏', 'cl': '2', 'lm': '-1', 'ie': 'utf-8', 'oe': 'utf-8', 'adpicid': '', 'st': '', 'z': '', 'ic': '', 'hd': '', 'latest': '', 'copyright': '', 'word': '彭于晏', 's': '', 'se': '', 'tab': '', 'width': '', 'height': '', 'face': '', 'istype': '', 'qc': '', 'nc': '1', 'fr': '', 'expermode': '', 'force': '', 'cg': 'star', 'pn': '30', 'rn': '30', 'gsm': '1e', } # 将编码形式转换为utf-8 response = requests.get(url=url, headers=header, params=param) response.encoding = 'utf-8' response = response.text print(response) |

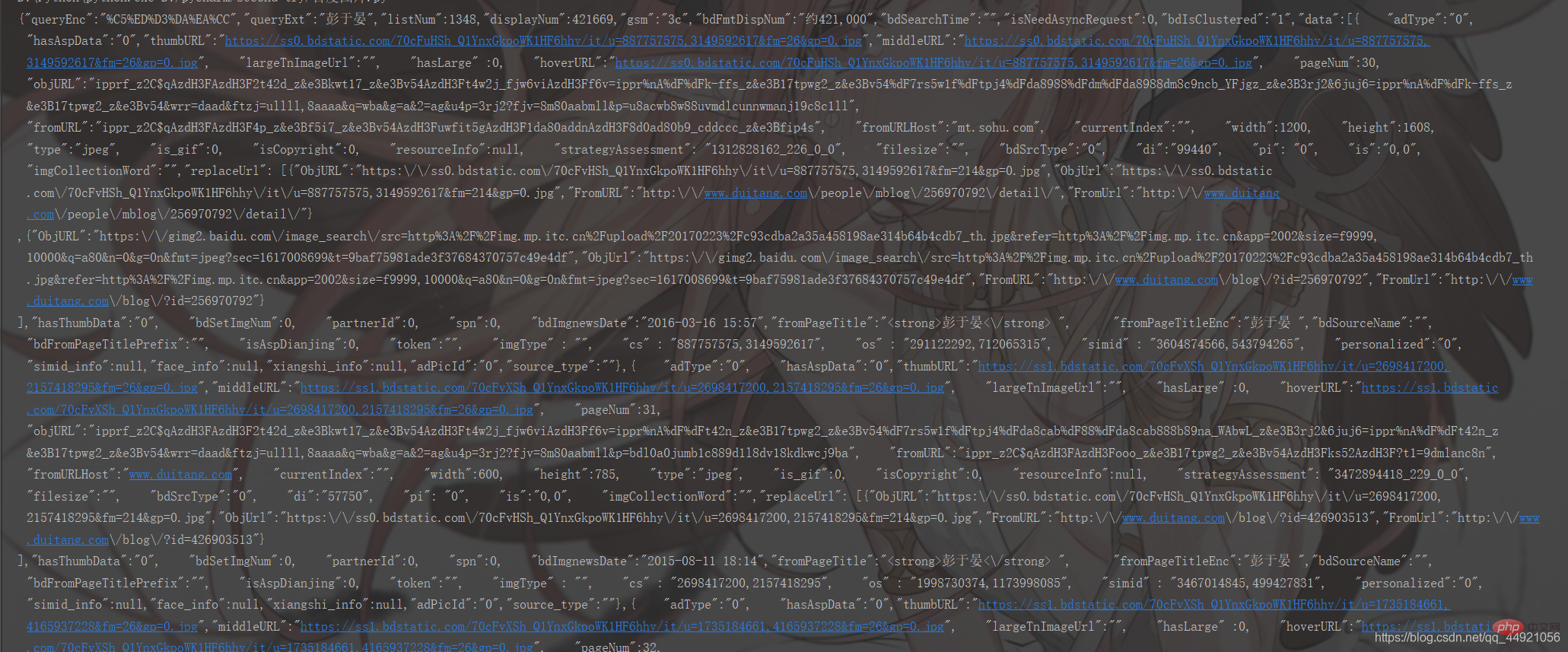

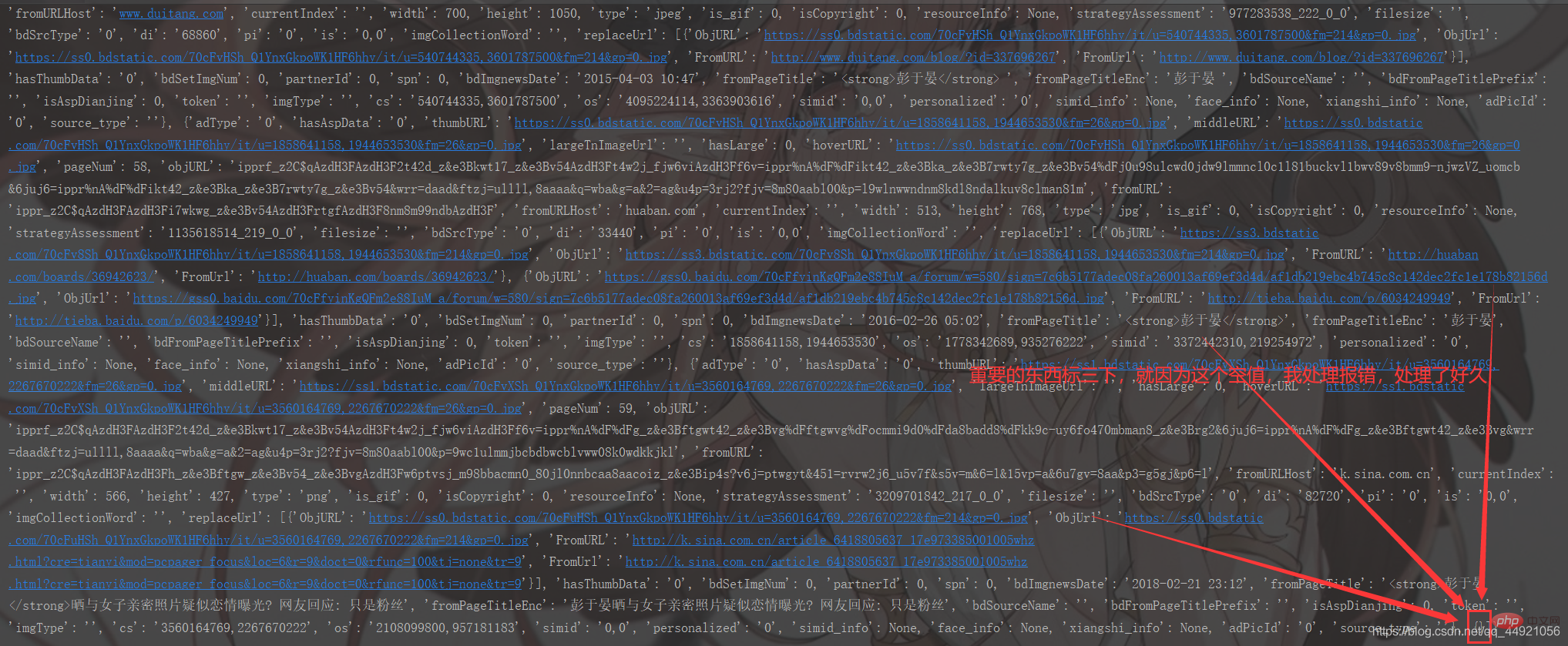

运行结果如下:

看上去挺乱的哈,没事,我们给包装一下!

在上面的基础上加上:

1 2 3 | # 把字符串转换成json数据 data_s = json.loads(response) print(data_s) |

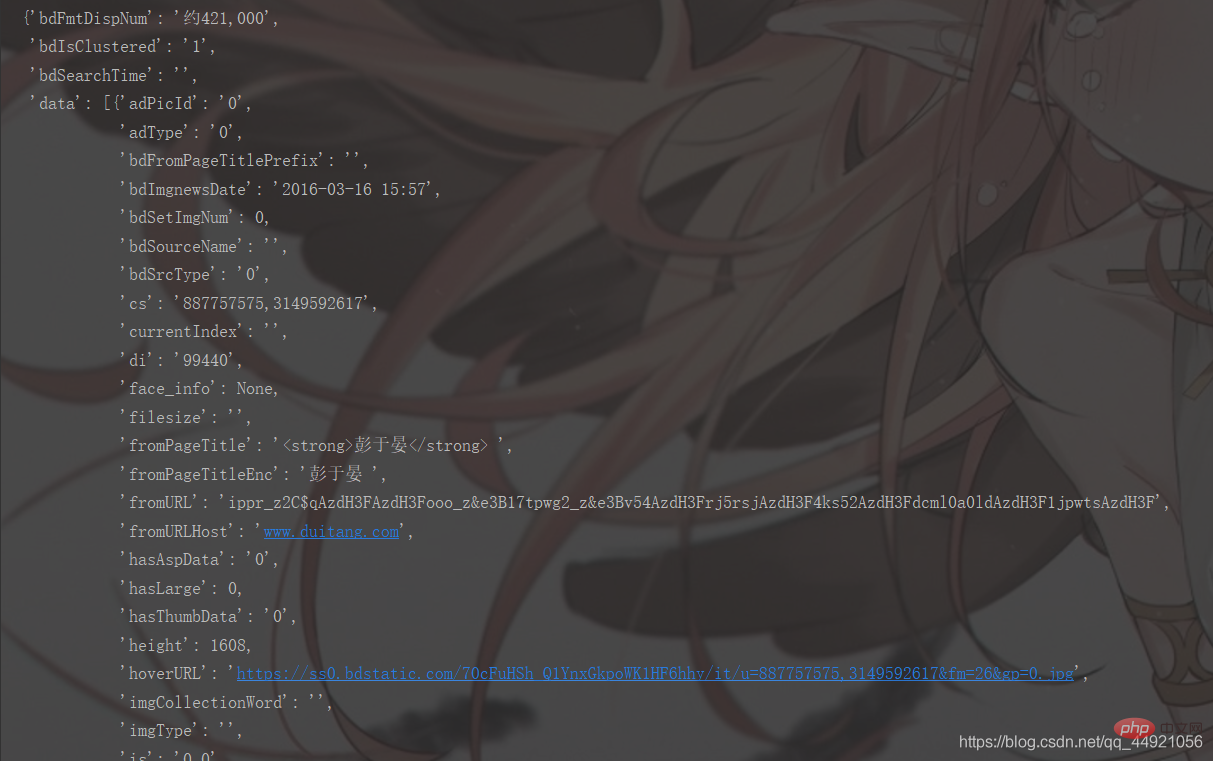

运行结果如下:

和上面相比,已经明晰很多了,但依旧不够明确,为什么呢?因为它打印的格式不方便我们观看!

对此,有两种解决办法。

①导入pprint库,接着输入pprint.pprint(data_s),就能打印啦,如下图

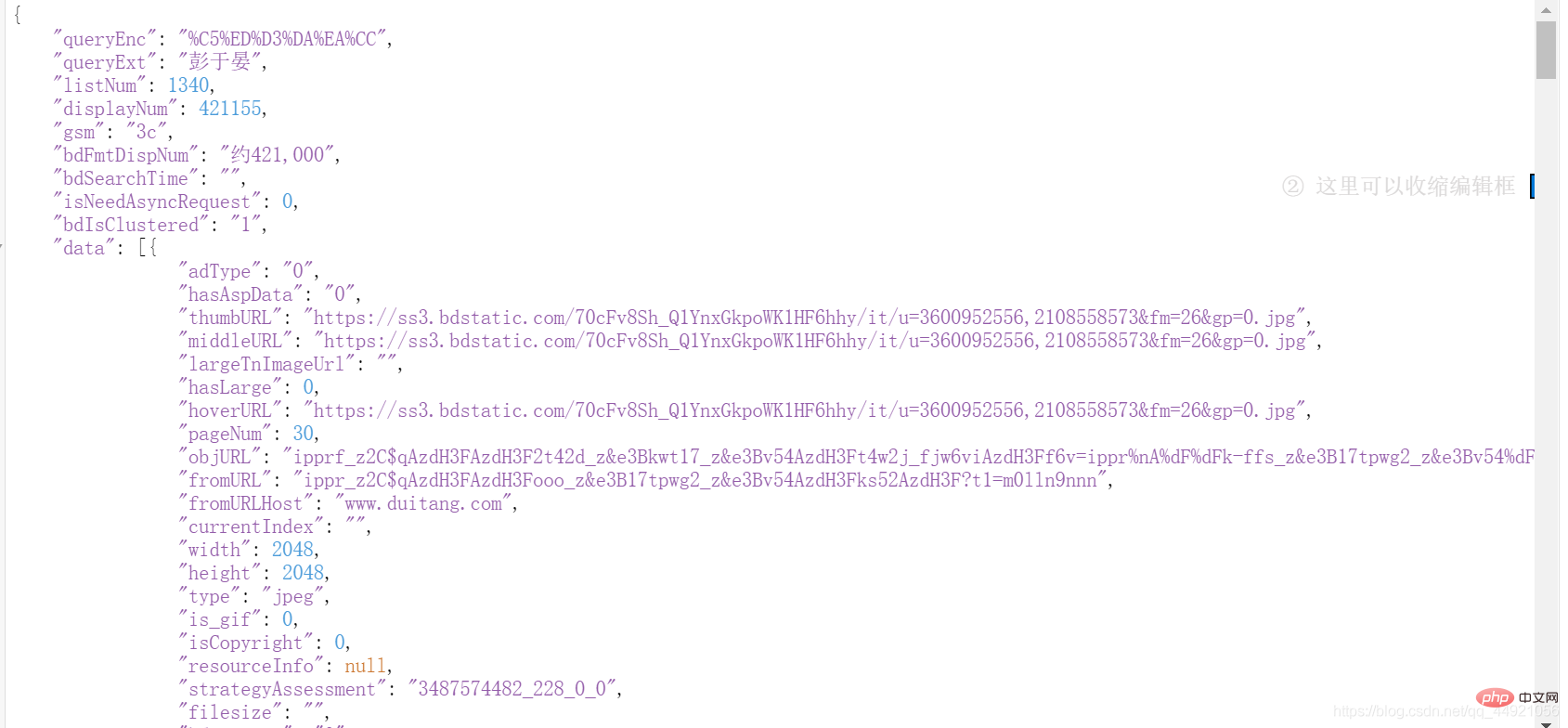

②使用json在线解析器(自行百度),结果如下:

解决掉上一步,我们会发现,想要的数据都在data里面!

那么就提取吧!

1 2 3 4 | a = data_s["data"] for i in range(len(a)-1): # -1是为了去掉上面那个空数据 data = a[i].get("thumbURL", "not exist") print(data) |

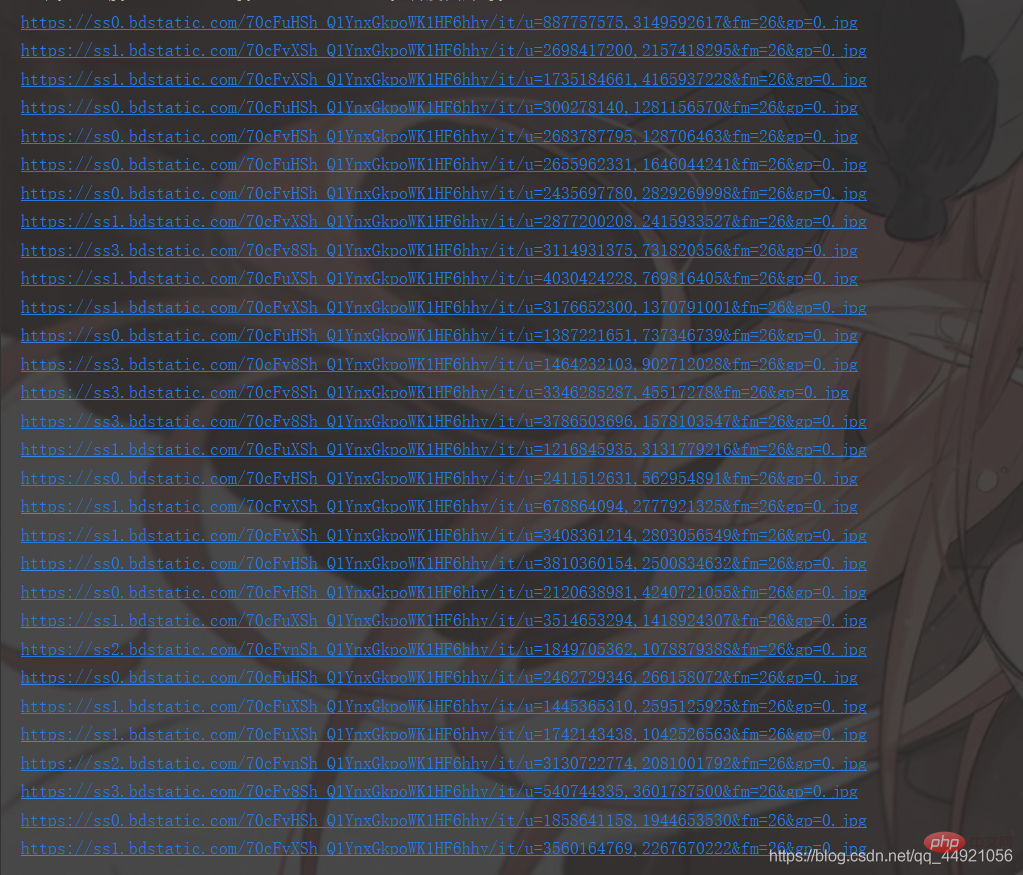

结果如下:

到这里,已经成功90%啦,剩下的就是保存和优化代码了!

这部分和上面有些许不同,仔细看看就会发现嗷!

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 | # -*- coding: UTF-8 -*-"""@Author :远方的星@Time : 2021/2/27 17:49@CSDN :https://blog.csdn.net/qq_44921056@腾讯云 : https://cloud.tencent.com/developer/user/8320044"""import requestsimport jsonimport osimport pprint# 创建一个文件夹path = 'D:/百度图片'if not os.path.exists(path): os.mkdir(path)# 导入一个请求头header = { 'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 11_1_0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'}# 用户(自己)输入信息指令keyword = input('请输入你想下载的内容:')page = input('请输入你想爬取的页数:')page = int(page) + 1n = 0pn = 1# pn代表从第几张图片开始获取,百度图片下滑时默认一次性显示30张for m in range(1, page): param = { 'tn': 'resultjson_com', 'logid': ' 7517080705015306512', 'ipn': 'rj', 'ct': '201326592', 'is': '', 'fp': 'result', 'queryWord': keyword, 'cl': '2', 'lm': '-1', 'ie': 'utf-8', 'oe': 'utf-8', 'adpicid': '', 'st': '', 'z': '', 'ic': '', 'hd': '', 'latest': '', 'copyright': '', 'word': keyword, 's': '', 'se': '', 'tab': '', 'width': '', 'height': '', 'face': '', 'istype': '', 'qc': '', 'nc': '1', 'fr': '', 'expermode': '', 'force': '', 'cg': 'star', 'pn': pn, 'rn': '30', 'gsm': '1e', } # 定义一个空列表,用于存放图片的URL image_url = list() # 将编码形式转换为utf-8 response = requests.get(url=url, headers=header, params=param) response.encoding = 'utf-8' response = response.text # 把字符串转换成json数据 data_s = json.loads(response) a = data_s["data"] # 提取data里的数据 for i in range(len(a)-1): # 去掉最后一个空数据 data = a[i].get("thumbURL", "not exist") # 防止报错key error image_url.append(data) for image_src in image_url: image_data = requests.get(url=image_src, headers=header).content # 提取图片内容数据 image_name = '{}'.format(n+1) + '.jpg' # 图片名 image_path = path + '/' + image_name # 图片保存路径 with open(image_path, 'wb') as f: # 保存数据 f.write(image_data) print(image_name, '下载成功啦!!!') f.close() n += 1 pn += 29 |

运行结果如下:

友情提示:

①:一页是30张

②:输入的内容可以很多变:比如桥、月亮、太阳、胡歌、赵丽颖等等。

四、Blogger’s speech

希望大家可以,点赞、关注、收藏,三连支持一下!

大量免费学习推荐,敬请访问python教程(视频)

以上就是python爬虫:随心所欲地爬取百度图片的详细内容,更多请关注zzsucai.com其它相关文章!