所属分类:php教程

程序员必备接口测试调试工具:立即使用

Apipost = Postman + Swagger + Mock + Jmeter

Api设计、调试、文档、自动化测试工具

后端、前端、测试,同时在线协作,内容实时同步

spark能跑Python么?

spark是可以跑Python程序的。python编写好的算法,或者扩展库的,比如sklearn都可以在spark上跑。直接使用spark的mllib也是可以的,大部分算法都有。

Spark 是一个通用引擎,可用它来完成各种各样的运算,包括 SQL 查询、文本处理、机器学习等。

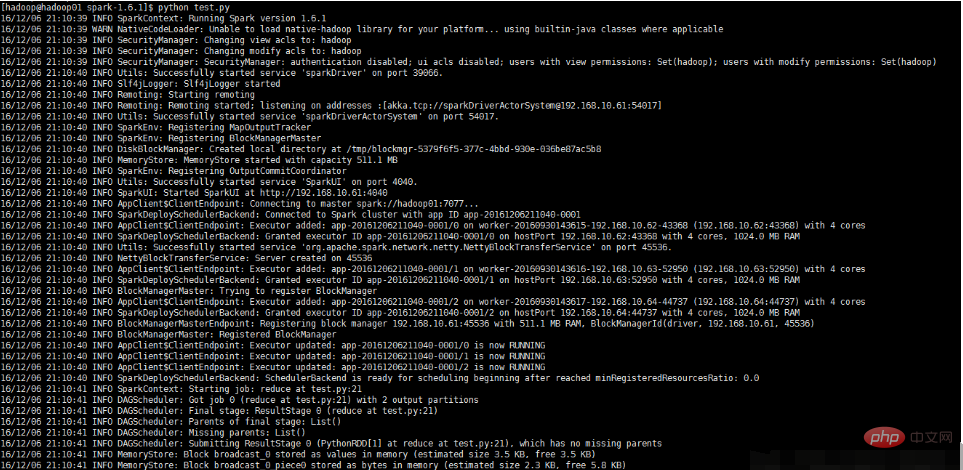

本次实验是搭有spark环境的linux下跑的,spark版本为1.6.1,相当于在在spark本地执行,spark文件放在/opt/moudles/spark-1.6.1/(代码中会看到)

编写python测试程序

#test.py文件

# -*- coding:utf-8 -*-

import os

import sys

#配置环境变量并导入pyspark

os.environ['SPARK_HOME'] = r'/opt/moudles/spark-1.6.1'

sys.path.append("/opt/moudles/spark-1.6.1/python")

sys.path.append("/opt/moudles/spark-1.6.1/python/lib/py4j-0.9-src.zip")

from pyspark import SparkContext, SparkConf

appName ="spark_1" #应用程序名称

master= "spark://hadoop01:7077"#hadoop01为主节点hostname,请换成自己的主节点主机名称

conf = SparkConf().setAppName(appName).setMaster(master)

sc = SparkContext(conf=conf)

data = [1, 2, 3, 4, 5]

distData = sc.parallelize(data)

res = distData.reduce(lambda a, b: a + b)

print("===========================================")

print (res)

print("===========================================")执行python程序

执行如下命令

python test.py

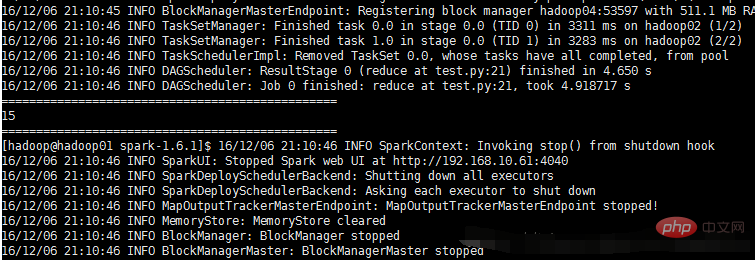

执行与结果分别如下图所示:

以上就是spark能跑Python么的详细内容,更多请关注zzsucai.com其它相关文章!